逼真的音频说话头像视频生成模型-VividTalk

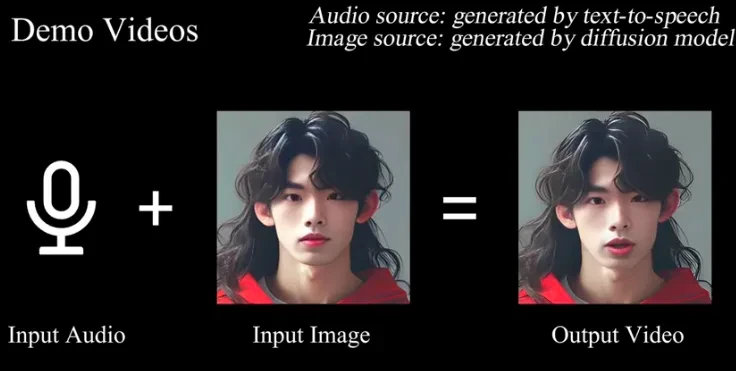

VividTalk是一个由南京大学、阿里巴巴、字节跳动和南开大学共同开发的项目工具,它通过音频到3D网格映射技术和网格到视频的转换技术,实现了高质量、逼真的音频驱动的说话头像视频生成。该技术使用一张静态照片和一段语音录音,即可制作出看起来像实际说话的视频,不仅支持多种语言和不同的风格,还具备卓越的视觉质量和逼真的面部表情及头部动作。

功能

- 音频到3D网格映射:VividTalk使用先进的算法将输入的音频映射到3D网格上,模拟表情运动和头部运动。这一过程中,它采用了混合形状(Blendshape)和顶点偏移(Vertex Offset)作为中间表示,以提供高度的表达能力。

- 网格到视频的转换:利用双分支运动-VAE(变分自编码器)和生成器,VividTalk将3D网格运动转化为2D视频。这一过程确保了运动的平滑性和视觉的连贯性。

- 表情和头部运动建模:VividTalk通过多分支Transformer网络充分利用长期音频上下文,建模音频与中间表示的关系,并创新性地提出了可学习的头部姿势代码本,以解决音频和头部运动之间的一对多映射问题。

- 支持多样语言和风格:VividTalk支持多种语言和不同的风格,包括真实风格和卡通风格等,提供了广泛的应用可能性。

优势

- 高质量的视觉效果:VividTalk生成的说话视频在面部表情、头部姿势和嘴唇同步方面均表现出色,优于以往的方法。

- 创新的两阶段框架:通过音频到网格生成和网格到视频生成两个阶段,VividTalk能够更准确地捕捉和再现复杂的面部和头部运动。

- 广泛的适用性:VividTalk不依赖于任何运动的先验知识,只需一张静态照片和一段音频即可生成视频,具有更高的灵活性和通用性。

应用场景

VividTalk技术可以应用于多个领域,包括虚拟助手、在线教育、娱乐内容制作等。然而,关于具体的落地案例,目前尚无详细的公开信息。但可以预见的是,随着技术的不断发展和完善,VividTalk将在这些领域发挥重要作用。

依靠的大模型介绍

VividTalk的技术实现依赖于多个大模型和算法,包括基于3D可塑模型(3DMM)的面部表情建模、基于多分支Transformer网络的音频到中间表示的建模、以及可学习的头部姿势代码本等。这些大模型和算法共同构成了VividTalk的核心技术体系。

相关导航

暂无评论...