lobe-chat

Lobe Chat项目详解

项目简介

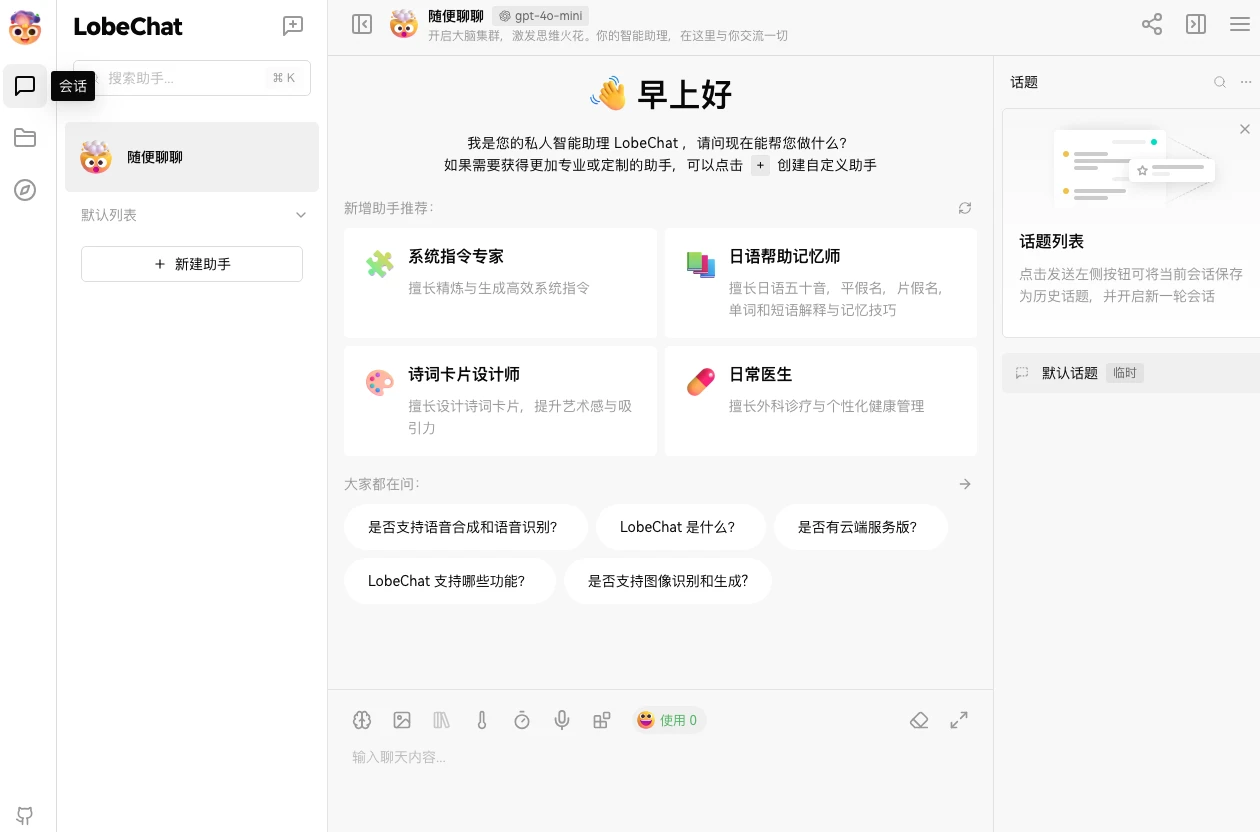

Lobe Chat旨在打造一个开源的、具有现代设计的AI聊天框架,为用户提供高度可定制化的AI聊天体验。它不仅支持多种AI模型服务提供商,还具备知识库管理、多模态交互等功能,目标是让开发者和用户能够轻松部署属于自己的私有AI聊天应用,如ChatGPT或Claude的替代品,并在一个统一的平台上灵活运用各种AI能力。

项目特点

丰富的功能集

- 文件上传与知识库:支持上传文档、图像、音频和视频等多种类型文件,并创建知识库。在对话中可利用这些文件和知识库,丰富对话体验,方便用户管理和搜索文件。

- 多模型服务提供商支持:目前已支持36种模型服务提供商,包括OpenAI、Anthropic、Google、Ollama等知名厂商。这种多样性允许用户根据自身需求,如成本、性能、功能特点等,灵活选择最适合的模型,满足不同场景下的应用需求。

- 本地大语言模型支持:基于Ollama支持本地模型使用,用户可灵活运用自有或第三方模型,满足特定的隐私、性能或个性化需求。

- 模型视觉识别:支持OpenAI的gpt – 4 – vision模型,用户能上传或拖拽图片至对话框,实现基于图像内容的智能对话,开创更智能多元的聊天场景。

- TTS与STT语音对话:集成文本转语音(TTS)和语音转文本(STT)技术,提供多种高质量语音选项,满足不同地区和文化背景用户需求,实现更自然的人机交互。

- 文本到图像生成:在对话中可直接调用图像创建工具,如DALL – E 3、MidJourney等,将想法转化为图像,为创意工作者提供便利。

- 插件系统(函数调用):拥有丰富插件生态,目前有48个插件,可实现实时信息获取与处理,如网页信息搜索、文档快速检索、与第三方服务交互等,增强助手实用性与灵活性。

- Agent市场(GPTs):汇聚众多精心设计的Agent,创作者可分享开发成果,平台具备自动化国际化(i18n)工作流程,方便用户提交Agent,促进生态发展。目前已有453个Agent。

- 支持本地/远程数据库:提供本地和服务器端数据库选择。本地数据库适合注重数据隐私用户,采用CRDT技术实现多设备同步;服务器端数据库选择PostgreSQL,适合追求便捷体验用户。

- 多用户管理:支持next – auth和Clerk两种用户认证与管理方案。next – auth灵活强大,支持多种认证方式;Clerk提供更高级功能,如多因素认证、用户资料管理等,满足不同安全与管理需求。

- 渐进式Web应用(PWA):采用PWA技术,在桌面和移动设备上提供接近原生应用的体验,界面设计精美,动画流畅,布局响应式,适配不同屏幕分辨率。

- 移动设备适配:针对移动设备进行优化设计,不断迭代提升移动体验,欢迎用户通过GitHub Issues或Pull Requests反馈建议。

- 自定义主题:提供灵活多样的主题模式,包括日间的浅色模式和夜间的深色模式,还支持颜色自定义,满足用户个性化需求,默认配置可智能识别系统颜色模式自动切换主题。

便捷与高效

- 快速部署:借助Vercel平台或Docker镜像,一键部署,1分钟内完成,无需复杂配置。

- 自定义域名:用户若有自有域名,可绑定至平台,方便快捷访问对话代理。

- 隐私保护:所有数据存储在用户本地浏览器,保障用户隐私。

- 精美UI设计:精心设计的界面,外观优雅,交互流畅,支持多种主题且适配移动设备,PWA支持带来更原生的体验。

- 流畅对话体验:提供流畅的对话响应,全面支持Markdown渲染,包括代码高亮、LaTex公式、Mermaid流程图等。

技术原理

多模型集成技术

Lobe Chat通过设计统一的接口层来集成多种模型服务提供商。对于不同模型的API,在接口层进行了封装和适配,使得上层应用能够以统一的方式调用不同模型的功能。例如,无论是OpenAI的GPT系列模型,还是Anthropic的Claude系列,都通过这个统一接口进行交互。这种设计方式不仅提高了代码的可维护性,也方便未来新增对其他模型的支持。在选择模型时,用户的请求会根据配置或用户指定,通过这个接口层转发到相应的模型服务提供商API,同时处理可能出现的错误和异常情况,确保系统的稳定性和可靠性。

知识库与RAG技术

知识库功能依赖于文件上传和知识管理模块。当用户上传文件时,系统会对文件内容进行解析和预处理,将其转化为适合存储和检索的格式。在对话过程中,使用基于检索的生成(RAG)技术,结合知识库中的信息来生成回复。RAG技术通过在知识库中检索与用户问题相关的信息,并将这些信息与语言模型相结合,使得生成的回答更加准确和有针对性。例如,在处理文档类问题时,系统会先在知识库中查找相关文档段落,然后将这些内容作为补充信息提供给语言模型,辅助其生成更符合用户需求的回答。

多模态交互实现

- 视觉识别:对于模型视觉识别功能,当用户上传图像时,系统利用OpenAI的gpt – 4 – vision模型的视觉识别能力。首先,图像数据会被编码并发送到模型API,模型对图像内容进行分析和理解,将其转化为语义信息。然后,结合用户输入的文本信息,模型进行综合处理,生成相应的回复。整个过程涉及到图像的预处理、特征提取以及与文本信息的融合等技术环节。

- 语音交互:在语音交互方面,TTS技术将文本转换为语音输出。系统根据用户选择的语音选项,调用相应的语音合成API(如OpenAI Audio、Microsoft Edge Speech),将文本内容合成为自然流畅的语音。STT技术则是将用户输入的语音转换为文本。语音数据首先经过降噪、采样等预处理步骤,然后通过语音识别模型进行识别,将语音信号转化为文本信息,供后续的语言模型处理。

插件系统架构

插件系统是Lobe Chat的重要扩展机制。插件通过定义特定的接口和协议与主系统进行交互。每个插件可以看作是一个独立的功能模块,实现特定的功能,如网页搜索、数据获取等。当用户触发插件相关的操作时,主系统会根据插件的定义,调用相应的插件代码。插件可以通过HTTP请求等方式与外部服务进行通信,获取实时信息。同时,插件系统还支持动态加载,即在运行时可以根据需要加载和卸载插件,提高系统的灵活性和可扩展性。

类似项目

ChatGPT(https://openai.com/blog/chatgpt/)

ChatGPT是OpenAI研发的聊天机器人程序,基于GPT – 3.5架构。它以强大的自然语言处理能力而闻名,能够生成连贯、准确且富有逻辑的对话回复。其预训练数据丰富,涵盖多种领域知识。然而,它是OpenAI的商业产品,用户无法直接对其进行二次开发和深度定制,数据使用也受到OpenAI政策限制。相比之下,Lobe Chat作为开源项目,用户可自由定制功能、集成其他模型,且更注重数据隐私,用户数据可选择本地存储。

LangChain(https://python.langchain.com/)

LangChain是一个用于开发由语言模型驱动的应用程序的框架,主要面向开发者。它提供了一系列工具、组件和接口,帮助开发者快速构建基于大语言模型的应用,如聊天机器人、智能文档处理等。但它更侧重于提供底层的开发工具和框架,对于普通用户而言,缺乏像Lobe Chat那样直观的用户界面和一站式的功能集成。Lobe Chat则在提供框架能力的同时,也为非技术用户提供了便捷的操作界面和丰富的预设功能。

Rasa(https://rasa.com/)

Rasa是一个开源的对话式AI框架,专注于构建智能聊天机器人,尤其适用于构建企业级的聊天机器人应用。它提供了强大的对话管理和自然语言理解功能,支持自定义对话流程和意图识别。与Lobe Chat不同,Rasa在模型选择上相对局限,主要依赖自身的机器学习模型和训练机制,而Lobe Chat支持多种外部模型服务提供商,为用户提供了更多选择。此外,Lobe Chat的多模态功能在Rasa中也相对欠缺。

Hugging Face Spaces(https://huggingface.co/spaces)

Hugging Face Spaces是Hugging Face平台提供的一项服务,允许用户快速部署和共享基于Hugging Face模型的应用程序,包括聊天应用。它集成了Hugging Face丰富的模型库,用户可以轻松选择和部署各种模型。但它的部署和应用构建相对更依赖于Hugging Face生态系统,而Lobe Chat的开放性更强,不仅支持Hugging Face模型,还集成了众多其他厂商的模型,并且在功能上,如知识库、多模态等方面有更丰富的特性。

Lobe Chat项目使用指南

环境配置

依赖环境

- Node.js:Lobe Chat是基于Node.js开发的,因此需要确保系统中安装了Node.js。建议使用较新的长期支持(LTS)版本,可从Node.js官方网站下载对应操作系统的安装包进行安装。安装完成后,在命令行中输入

node -v,若输出版本号,则说明安装成功。 - 包管理器:项目使用

pnpm作为包管理器,虽然也可以使用npm,但pnpm在依赖管理和安装速度上有一定优势。如果尚未安装pnpm,可以通过以下命令进行安装:npm install -g pnpm。安装完成后,在命令行中输入pnpm -v,输出版本号则安装成功。

环境变量配置

- OPENAI_API_KEY:如果要使用OpenAI的模型服务,这是必需的环境变量。在OpenAI官网申请API Key,然后将其设置为该环境变量的值。例如:

sk-xxxxxx...xxxxxx。如果使用其他模型服务提供商,此变量可能不需要或有不同的用途。 - OPENAI_PROXY_URL:可选环境变量,当需要通过代理访问OpenAI接口时使用。如果手动配置OpenAI接口代理,可以用此配置项覆盖默认的OpenAI API请求基础URL。例如:

https://api.chatanywhere.cn或https://aihubmix.com/v1,默认值为https://api.openai.com/v1。 - ACCESS_CODE:可选环境变量,用于为服务添加访问密码。可以设置一个较长的密码以避免泄露,如果值包含逗号,则表示是一个密码数组。例如:

awCTe)re_r74或rtrt_ewee3@09!或code1,code2,code3。 - OPENAI_MODEL_LIST:可选环境变量,用于控制模型列表。使用

+添加模型,-隐藏模型,model_name=display_name自定义模型的显示名称,各配置项之间用逗号分隔。例如:qwen-7b-chat,+glm-6b,-gpt-3.5-turbo。完整的环境变量列表可参考环境变量文档。

安装

方式一:使用Vercel、Zeabur、Sealos或阿里云部署

- 准备工作:准备好OpenAI API Key(如果使用OpenAI模型)。

- 开始部署:点击相应平台的部署按钮(如

Deploy with Vercel、Deploy with Zeabur等),直接使用GitHub账号登录。登录后,记得在环境变量部分填写OPENAI_API_KEY(必需)和ACCESS_CODE(推荐)。 - 完成部署:部署完成后,即可开始使用。如果需要,还可以绑定自定义域名(可选)。由于Vercel分配的域名DNS在某些地区可能被污染,绑定自定义域名可直接连接。

- 保持更新:如果按照README中的一键部署步骤部署了自己的项目,可能会遇到持续提示“有可用更新”的问题。这是因为Vercel默认创建新项目而不是fork本项目,导致无法准确检测更新。建议按照自动同步最新版本文档中的步骤重新部署。

方式二:使用Docker部署

- 拉取镜像:在命令行中执行以下命令拉取Lobe Chat的Docker镜像:

docker pull lobehub/lobe-chat。 - 启动服务:使用以下命令启动Lobe Chat服务:

$ docker run -d -p 3210:3210

-e OPENAI_API_KEY=sk-xxxx

-e ACCESS_CODE=lobe66

--name lobe-chat

lobehub/lobe-chat

- 配置代理(可选):如果需要通过代理使用OpenAI服务,可以使用

OPENAI_PROXY_URL环境变量配置代理地址:

$ docker run -d -p 3210:3210

-e OPENAI_API_KEY=sk-xxxx

-e OPENAI_PROXY_URL=https://api-proxy.com/v1

-e ACCESS_CODE=lobe66

--name lobe-chat

lobehub/lobe-chat

详细的Docker部署说明,请参考Docker部署指南。

方式三:本地开发安装

- 克隆项目:在命令行中执行以下命令克隆Lobe Chat项目到本地:

git clone https://github.com/lobehub/lobe-chat.git。 - 进入项目目录:克隆完成后,进入项目目录:

cd lobe-chat。 - 安装依赖:使用

pnpm安装项目所需的依赖:pnpm install。 - 启动项目:执行

pnpm dev命令启动项目,启动成功后,可在浏览器中访问指定地址查看项目。

使用

知识库功能

- 文件上传:Lobe Chat支持上传多种类型的文件,如文档、图像、音频和视频等。在界面中找到文件上传入口,点击后选择本地文件即可上传。上传后的文件会被添加到知识库中。

- 创建知识库:可以根据需求创建不同的知识库,方便对文件进行分类管理。例如,为工作相关的文件创建一个知识库,为学习资料创建另一个知识库。

- 在对话中使用:在与聊天机器人对话时,可以引用知识库中的文件和知识,让聊天机器人基于这些信息进行更有针对性的回答,丰富对话体验。例如,上传一份产品说明书,在询问产品相关问题时,聊天机器人可以结合说明书内容进行回答。

多模型服务提供商支持

- 选择模型:Lobe Chat支持众多模型服务提供商,如OpenAI、Anthropic、Google等。在设置或对话界面中,可以找到模型选择的选项,根据需求选择合适的模型。不同的模型在性能、适用场景等方面可能有所差异,例如,OpenAI的GPT系列模型在自然语言处理方面表现出色,而Google的Gemini系列模型具有多模态能力。

- 模型切换:在使用过程中,可以根据实际需求随时切换模型。比如,在进行简单的文本对话时使用一个轻量级模型以提高速度,在进行复杂的文本生成任务时切换到功能更强大的模型。

本地大语言模型(LLM)支持

- 基于Ollama使用本地模型:如果选择使用本地模型,Lobe Chat支持基于Ollama来实现。先确保已经安装并配置好Ollama,然后在Lobe Chat的相关设置中选择使用本地模型,并进行相应的参数配置。这样就可以使用自己的或第三方的本地模型进行聊天。

- 模型优势:使用本地模型可以在一定程度上保护数据隐私,并且对于一些对数据安全要求较高的场景更为适用。同时,也可以根据实际需求选择更符合特定任务的本地模型。

模型视觉识别

- 使用gpt – 4 – vision模型:Lobe Chat支持OpenAI的gpt – 4 – vision模型的视觉识别功能。在对话界面中,用户可以轻松上传或拖放图像到对话框。聊天机器人能够识别图像内容,并基于此进行智能对话,创造更智能、多样化的聊天场景。

- 应用场景:例如,在分享旅游照片时,聊天机器人可以识别照片中的景点,并提供相关的介绍和旅游建议;在工业场景中,可以识别产品图片,进行质量检测和问题分析等。

TTS & STT语音对话

- 语音交互:Lobe Chat支持文本转语音(TTS)和语音转文本(STT)技术。用户可以选择多种语音与聊天机器人进行语音交互,仿佛在与真人对话。例如,在不方便打字的情况下,通过语音输入问题,聊天机器人将以语音形式回答。

- 语音选择:提供了如OpenAI Audio、Microsoft Edge Speech等多种高质量语音选项,满足不同地区和文化背景用户的需求。用户可以根据个人喜好或特定场景选择合适的语音。

文本转图像生成

- 图像生成:在与聊天机器人对话时,用户可以调用图像生成工具。借助DALL – E 3、MidJourney、Pollinations等AI工具的能力,将想法转化为图像。例如,描述“一座漂浮在云端的城堡”,聊天机器人会调用图像生成工具生成相应的图像。

- 创意实现:这一功能为用户提供了更私密和沉浸式的创作过程,能够将视觉故事融入与聊天机器人的对话中,激发创意和想象力。

插件系统(函数调用)

- 插件使用:Lobe Chat的插件生态系统极大地增强了其核心功能的实用性和灵活性。通过插件,聊天机器人可以获取和处理实时信息,如搜索网页信息、快速搜索文档、从Bilibili和Steam等平台获取数据等。例如,使用“Google CSE”插件可以通过Google官方CSE API进行网页搜索。

- 插件安装与管理:在插件市场中,可以浏览和安装各种插件。已安装的插件可以在设置或相关界面中进行管理,如启用、禁用或更新插件。

代理市场(GPTs)

- 探索与使用代理:在Lobe Chat代理市场中,创作者可以发现众多精心设计的代理,这些代理在工作和学习场景中都能提供很大帮助。例如,“System Instruction Expert”代理擅长提炼和生成高效的系统指令,“Japanese Memory Helper”代理专注于日语假名、词汇和记忆技巧的讲解。

- 提交代理:用户也可以通过

🤖/🏪 Submit Agents轻松提交自己创建的代理到平台。Lobe Chat具备自动化的国际化(i18n)工作流程,能将代理无缝翻译成多种语言版本,方便不同语言的用户使用。

多用户管理

- next – auth:Lobe Chat集成了next – auth,这是一个灵活且强大的身份验证库,支持多种身份验证方法,如OAuth、电子邮件登录、凭证登录等。通过next – auth,可以轻松实现用户注册、登录、会话管理、社交登录等功能,保障用户数据的安全和隐私。

- Clerk:对于需要更高级用户管理功能的场景,Lobe Chat还支持Clerk,这是一个现代用户管理平台。Clerk提供了更丰富的功能,如多因素认证(MFA)、用户资料管理、登录活动监控等,能够满足复杂的用户管理需求。

渐进式Web应用(PWA)

- 安装PWA:如果不熟悉PWA的安装过程,可以按照以下步骤将Lobe Chat添加为桌面应用(也适用于移动设备):

- 启动Chrome或Edge浏览器。

- 访问Lobe Chat网页。

- 在地址栏右上角,点击安装图标。

- 按照屏幕上的说明完成PWA安装。

- PWA优势:通过PWA技术,Lobe Chat在桌面和移动设备上都能提供高度优化的用户体验,同时保持轻量级和高性能的特点。在视觉和操作感受上,与原生应用无异,提供流畅的动画效果、响应式布局,并能适应不同设备的屏幕分辨率。

移动设备适配

Lobe Chat针对移动设备进行了一系列优化设计,以提升用户的移动体验。目前仍在不断迭代移动用户体验,以实现更流畅、直观的交互。如果用户有任何建议或想法,欢迎通过GitHub Issues或Pull Requests提供反馈。

自定义主题

- 主题模式切换:Lobe Chat提供了灵活多样的主题模式,包括适合白天使用的浅色模式和适合夜间使用的深色模式。用户可以根据自己的喜好和使用场景在两种模式之间切换。

- 颜色自定义:除了主题模式切换,还提供了一系列颜色自定义选项。用户可以根据个人喜好调整应用的主题颜色,无论是沉稳的深蓝色、活泼的桃粉色还是专业的灰白色,都能在Lobe Chat中找到适合自己风格的颜色选择。同时,默认配置能够智能识别用户系统的颜色模式,并自动切换主题,确保与操作系统的视觉体验保持一致。对于喜欢手动控制细节的用户,Lobe Chat也提供了直观的设置选项,并且在对话场景中可以选择聊天气泡模式或文档模式。

注意事项

模型使用限制

- API使用限制:如果使用OpenAI等模型服务提供商的API,需要注意其使用限制,如API调用频率限制、数据用量限制等。超出限制可能导致服务中断或产生额外费用。应根据实际需求合理规划API的使用,避免不必要的问题。

- 模型性能差异:不同的模型服务提供商和模型版本在性能、功能和适用场景上存在差异。在选择模型时,需要根据具体任务和需求进行评估,以获得最佳的使用效果。例如,某些模型在处理长文本时表现更好,而某些模型在特定领域的知识问答上更具优势。

数据安全与隐私

- 本地数据存储:Lobe Chat声称所有数据默认存储在用户浏览器本地,以确保用户隐私。然而,在使用过程中,特别是涉及敏感信息时,仍需谨慎。例如,不要在聊天中输入过于敏感的个人信息、商业机密等,以免因意外情况导致信息泄露。

- 第三方服务集成:当使用一些第三方服务(如某些插件或模型服务提供商)时,需要注意这些服务的隐私政策。部分第三方服务可能会收集用户数据,应了解其数据收集和使用方式,确保个人隐私得到保护。

插件相关问题

- 插件兼容性:虽然Lobe Chat不断完善插件系统,但部分插件可能存在兼容性问题。在安装和使用插件时,如果遇到异常情况,如插件无法正常工作、导致应用崩溃等,应及时停用插件,并查看插件的官方文档或在社区中寻求解决方案。

- 插件安全性:由于插件可能来自不同的开发者,其安全性无法完全保证。在安装插件时,应尽量选择来自官方或可信赖来源的插件,避免安装不明来源的插件,以防引入安全风险,如恶意代码注入、数据泄露等问题。

官网: https://chat-preview.lobehub.com/

项目地址: https://github.com/lobehub/lobe-chat