stable-diffusion-webui

项目简介

项目背景

随着人工智能技术的飞速发展,特别是生成式对抗网络(GAN)和扩散模型等相关技术的兴起,图像生成领域迎来了巨大变革。Stable Diffusion作为一种强大的文本到图像生成模型,具备生成高质量图像的能力,但对于普通用户和开发者来说,直接使用其进行图像生成操作往往不够便捷。为了让更多人能够轻松地利用Stable Diffusion的强大功能,AUTOMATIC1111开发了stable-diffusion-webui这个项目,它通过构建一个易于操作的Web界面,将Stable Diffusion模型的使用门槛大大降低,使得无论是专业的研究人员、开发者,还是普通的图像创作爱好者,都可以方便地基于该模型进行图像生成等相关操作。

项目目标

该项目旨在提供一个功能丰富、易于使用且高度可定制的Web界面,用于Stable Diffusion模型的交互。一方面,让没有深厚编程基础和复杂命令行操作经验的用户能够通过直观的界面输入文本提示,快速生成符合期望的图像;另一方面,为开发者提供足够的灵活性和扩展性,方便他们基于此项目进一步集成新的功能、优化算法或者针对特定场景进行定制化开发,同时也助力推动图像生成技术在更多领域的应用,比如艺术创作、影视制作、游戏开发等。

项目特点

便捷的安装与运行机制

它具备一键安装和运行脚本,尽管前提是用户需要先安装好Python和Git等基础环境。但相对来说,这样的设计极大地简化了整个流程,尤其是对于Windows、Linux以及Apple Silicon等不同操作系统,都给出了相应详细且较为清晰的安装指南,涵盖了从依赖安装到具体脚本执行的各个环节,方便不同系统的用户能够快速上手进行部署使用。

丰富多样的图像生成功能

- 基础生成模式齐全:支持原始的txt2img(文本到图像)和img2img(图像到图像)模式,满足了用户从无到有生成图像以及基于已有图像进行再创作的常见需求。

- 图像编辑与优化功能丰富:例如提供了Outpainting(图像外绘扩展)、Inpainting(图像修复)、Color Sketch(色彩草图)、Prompt Matrix(提示矩阵)等功能,能够让用户对生成图像的细节、色彩、构图等方面进行精细化控制和调整,从而生成更符合创意和审美要求的图像。

- 高级图像调整选项众多:可以指定Attention(注意力机制),通过调整文本中不同部分的权重,让模型重点关注特定内容,比如可以通过“a man in a ((tuxedo))”这样的提示让模型着重关注“tuxedo”;支持Loopback(循环处理)、X/Y/Z plot(多维图像参数绘图)等,方便从不同角度探索图像生成的效果;还有Textual Inversion(文本反转)功能,允许用户自由定义和使用嵌入向量,并且可以使用多个不同向量的嵌入,甚至在低显存的情况下(如8GB甚至6GB)也能进行嵌入向量的训练。

- 图像后处理能力强大:在Extras tab中集成了GFPGAN(用于面部修复)、CodeFormer(面部还原工具)、RealESRGAN、ESRGAN等多种神经网络超分工具以及SwinIR、Swin2SR、LDSR等不同的图像超分辨率放大工具,同时还能选择不同的采样方法、调整采样器的eta值(噪声乘数)等更高级的噪声设置选项,并且支持随时中断图像生成过程,对生成的图像进行多样化的后处理和优化。

灵活的交互与定制特性

- UI交互友好:提供鼠标悬停提示,方便用户了解各个UI元素的功能;能够通过文本配置更改UI元素的默认值、最小值、最大值、步长等参数;支持Tiling(图像平铺)功能,可创建类似纹理的可平铺图像;还有进度条以及实时图像生成预览功能,让用户可以直观地看到图像生成的进度和效果。

- 高度可定制化:用户可以在Settings页面运行任意Python代码(需启用–allow-code参数),能够自定义各种生成参数,还可以调整UI元素顺序、加载不同的VAE(变分自编码器),而且支持自定义脚本,社区也贡献了众多扩展脚本,像Composable-Diffusion(组合式扩散)等,可以实现更复杂、个性化的图像生成需求,例如使用多个带权重的提示词同时进行图像生成等。

良好的兼容性与扩展性

它支持多种硬件设备,包括但不限于NVidia GPUs、AMD GPUs、Intel CPUs以及Intel GPUs(集成和独立显卡)等,甚至对于不同显存大小的显卡也有相应的优化和适配,比如有报告显示4GB甚至2GB显存的显卡也能支持部分功能运行。同时,通过扩展机制可以方便地集成新的功能,例如可以接入Aesthetic Gradients(审美梯度)这样通过CLIP图像嵌入生成特定审美风格图像的功能,以及支持特定的Inpainting模型等,方便不断拓展其应用场景和功能边界。

技术原理

核心技术架构剖析

stable-diffusion-webui主要是基于Stable Diffusion模型构建的Web界面应用。Stable Diffusion本身是一种基于扩散模型的图像生成技术,其核心在于通过对噪声的逐步去噪过程,依据给定的文本提示来生成对应的图像。在这个项目中,利用Gradio库实现了Web界面,将模型的输入输出接口进行了友好的封装,使得用户可以通过网页端直观地输入文本提示等参数,并接收生成的图像结果。

在后端,它需要协调Python环境下的各种依赖库,例如处理图像数据的相关库、深度学习框架PyTorch等,来驱动Stable Diffusion模型进行正向的图像生成推理过程。同时,还涉及到对生成过程中的各种参数控制和状态监控,比如采样方法的选择、噪声水平的调整等,都需要通过代码逻辑与模型的交互来实现精准的控制,以达到用户期望的图像生成效果。

对比不同技术路径

在图像生成领域,除了Stable Diffusion及其相关的Web界面应用外,还有像GAN(生成式对抗网络)相关的图像生成技术和应用。GAN主要通过生成器和判别器的对抗训练来生成图像,其优势在于生成的图像在某些特定场景下可能具有较高的清晰度和逼真度,但训练过程相对复杂且容易出现模式崩溃等问题。

而Stable Diffusion这类基于扩散模型的技术,它基于概率分布的逐步调整来生成图像,优势在于能够更好地处理复杂的文本提示,生成的图像在多样性和符合语义描述方面表现较好,并且相对来说训练过程更加稳定、对数据的要求没有GAN那么苛刻。stable-diffusion-webui正是基于这种更具优势的扩散模型技术路径,通过界面化的方式让其优势更好地发挥出来,降低了用户使用难度。

技术创新点

- UI交互创新:它创新性地将复杂的深度学习模型操作封装在一个简洁直观的Web界面中,对于普通用户来说,无需了解复杂的模型架构和代码逻辑,只需通过简单的文本输入、参数调整等操作就能完成图像生成,这在用户体验和技术应用普及方面是一个重要的创新。

- 功能整合与拓展创新:整合了众多图像生成、编辑、后处理等功能,并且通过开放的扩展机制,鼓励社区开发者贡献更多的功能模块,形成了一个功能生态不断丰富的平台,使得整个项目的功能边界不断拓展,能够满足不同用户在不同场景下的多样化需求,这也是区别于传统单一功能图像生成工具的创新之处。

- 跨平台与硬件适配创新:在不同操作系统以及多种硬件设备上进行了较好的适配,尤其是针对不同显卡的显存等特性进行优化,让更多用户能够利用手头现有的硬件资源来体验和使用图像生成技术,拓宽了图像生成技术的应用范围和受众群体。

类似项目

StableDiffusion-WebUI-Alternative

这是另外一个针对Stable Diffusion模型构建的Web界面项目。它同样致力于让用户更便捷地使用Stable Diffusion进行图像生成,但在功能侧重和界面设计上可能有所不同。它可能更注重某些特定图像风格的快速生成,在界面交互上更偏向简洁高效,对于一些只需要简单输入文本提示快速获取特定风格图像的用户来说,是一个不错的选择。其项目地址为[具体项目地址],用户可以通过访问该项目进一步了解其详细特点和使用方式。

Another-StableDiffusion-UI

该项目也是围绕Stable Diffusion打造的可视化交互界面。其特点在于与一些特定的图像数据集或者艺术风格库进行了深度整合,能够让用户在生成图像时更方便地参考和借鉴已有的艺术风格,从而生成带有独特艺术韵味的图像。同时,在图像生成参数的可视化调整方面也有自己的独到之处,提供了更直观的图形化参数调节界面,方便用户探索不同参数组合对图像的影响。项目地址为[对应项目地址],感兴趣的用户可以前往查看并尝试使用。

Custom-StableDiffusion-Interface

如其名称所示,这是一个注重用户自定义的Stable Diffusion界面项目。它提供了更强大的模板和样式编辑功能,用户可以根据自己的喜好和使用习惯,定制出完全符合个人风格的图像生成界面,从界面布局到功能按钮的排列等都能进行个性化设置。并且在与外部图像编辑软件的协同方面也做了一些优化,方便用户将生成的图像快速导入到其他专业图像编辑工具中进一步处理。项目地址为[相关项目链接],值得有个性化需求的用户去探索和使用。

环境配置

操作系统相关依赖

- Windows系统:

- 若采用发布包在Windows 10/11上使用NVIDIA-GPUs进行安装,需先下载

sd.webui.zip(从v1.0.0-pre版本)并解压内容,接着运行update.bat以及run.bat。 - 自动安装方式下,要安装Python 3.10.6(因为新版本Python可能不支持torch,安装时需勾选“Add Python to PATH”选项),同时安装

git。之后通过运行git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git下载项目仓库,再从Windows资源管理器以普通非管理员用户身份运行webui-user.bat即可。

- 若采用发布包在Windows 10/11上使用NVIDIA-GPUs进行安装,需先下载

- Linux系统:

- 首先要安装对应的依赖项,对于Debian系系统,需执行

sudo apt install wget git python3 python3-venv libgl1 libglib2.0-0;Red Hat系系统执行sudo dnf install wget git python3 gperftools-libs libglvnd-glx;openSUSE系系统执行sudo zypper install wget git python3 libtcmalloc4 libglvnd;Arch系系统执行sudo pacman -S wget git python3。 - 若系统较新,可能需要安装python3.11或python3.10,比如Ubuntu 24.04下,要先执行

sudo add-apt-repository ppa:deadsnakes/ppa,再sudo apt update然后sudo apt install python3.11;在Manjaro/Arch下,先执行sudo pacman -S yay,再yay -S python311(注意不要和python3.11包混淆,仅针对3.11版本),随后在启动脚本(如launch.py)或者webui-user.sh里设置环境变量export python_cmd="python3.11"(依实际情况选择设置位置)。完成这些后,导航到期望安装webui的目录,执行wget -q https://raw.githubusercontent.com/AUTOMATIC1111/stable-diffusion-webui/master/webui.sh命令,或者直接在想要的位置克隆仓库git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui,最后运行webui.sh,还可以查看webui-user.sh了解相关选项。

- 首先要安装对应的依赖项,对于Debian系系统,需执行

- Apple Silicon系统:需查找对应专门的安装说明进行环境配置。

软件及库依赖

- Python:项目主要基于Python开发,要确保安装了合适版本的Python(如前面提到的Windows下推荐3.10.6等),并且Python环境配置正确,相关的路径等设置无误,以便后续能顺利运行项目中的Python脚本等内容。

- Git:用于从GitHub上克隆项目仓库,获取项目代码,所以需提前安装好

git工具,并且保证能正常连接到GitHub进行代码拉取操作。 - 其他依赖库:在项目运行过程中,还依赖诸多Python库,像

torch等深度学习相关库用于模型的加载、运算等操作,以及gradio库用于构建Web界面方便交互等。这些依赖库在后续安装步骤或者项目启动时会根据配置文件(如requirements.txt等)自动安装或者进行相关提示,确保按要求安装好相应版本的依赖库才能保证项目正常运行。

安装

克隆项目仓库

无论在Windows、Linux还是Apple Silicon系统下,都首先需要获取项目代码,通用的方式是通过 git 命令进行克隆,在命令行中执行 git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git ,这样就能将整个项目代码下载到本地指定的目录下,方便后续的安装和使用。

安装依赖库

- 在完成项目仓库克隆后,对于不同的操作系统,前面提到的环境配置步骤中已经涉及到部分依赖库的安装,比如Linux下通过系统包管理器安装各种基础依赖。在此基础上,项目根目录下一般有

requirements.txt等文件,里面列出了项目运行所需的Python库及其版本要求。在命令行进入项目根目录后,可以通过pip install -r requirements.txt命令(前提是已经正确安装Python和pip工具)来安装这些Python依赖库,确保项目运行所需要的各种功能模块都能正常调用。

配置相关参数

- Windows系统下:在

webui-user.bat文件中,可以根据自身硬件情况(比如GPU类型、显存大小等)以及期望的运行参数(例如是否开启某些特定功能、设置日志级别等)来调整相关配置参数。例如,如果想开启xformers加速(对于支持的显卡),可以添加对应的命令行参数--xformers。 - Linux系统下:类似地,在

webui.sh或者webui-user.sh文件中配置相关参数,像设置Python的版本对应的命令(前面提到的python_cmd变量设置等情况),以及其他运行相关的自定义参数,满足不同的使用场景需求。

启动项目

- Windows系统:在完成上述安装和配置后,直接双击运行

webui-user.bat文件(以普通非管理员用户身份),即可启动stable-diffusion-webui项目,它会在本地开启一个Web服务,并且自动打开默认浏览器进入对应的Web界面。 - Linux系统:在命令行进入项目所在目录后,执行

./webui.sh命令来启动项目,同样会启动Web服务并打开浏览器进入操作界面,之后就可以在界面上进行各种操作了。

使用

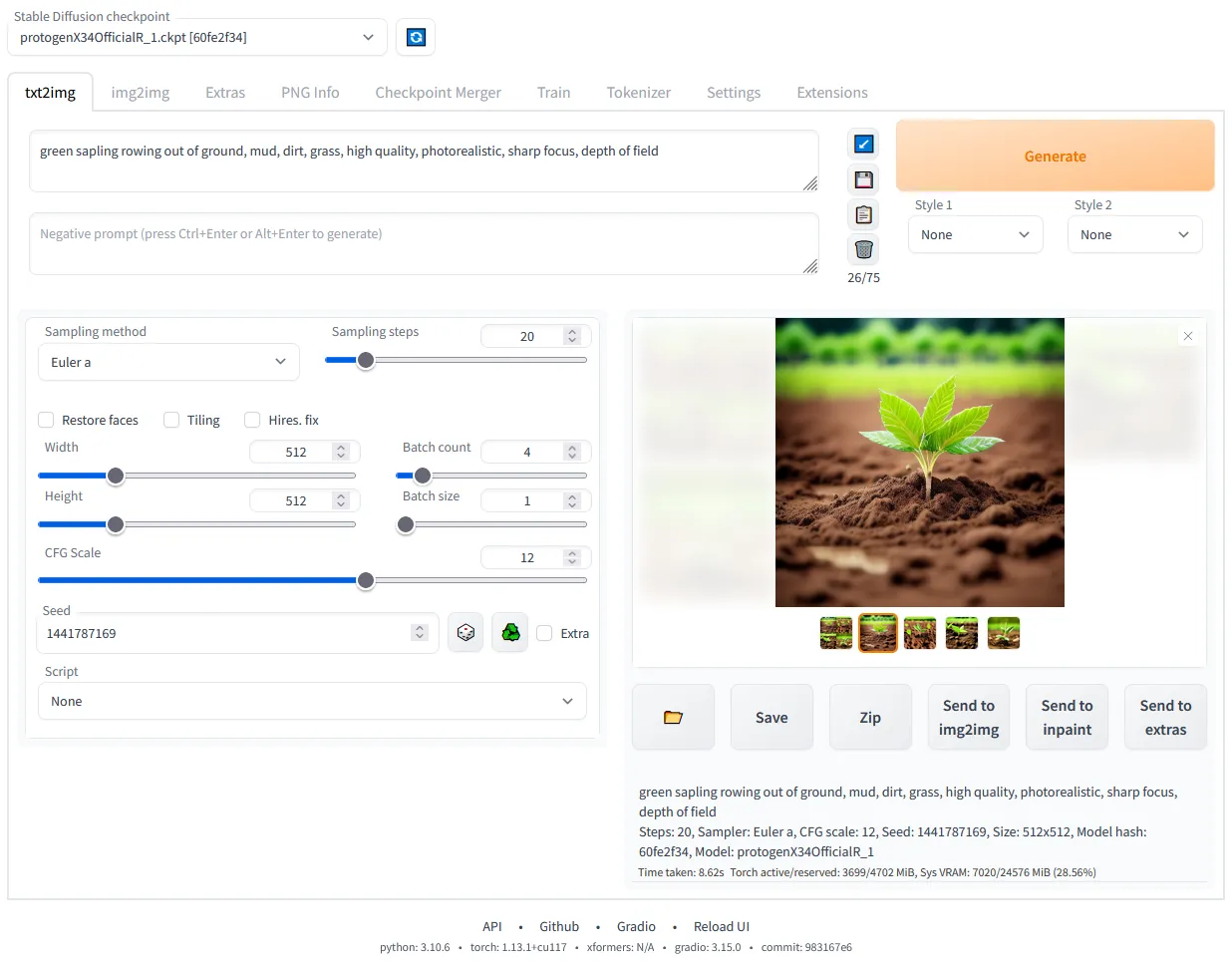

Web界面功能模块介绍

- 图像生成相关:

- txt2img模式:在文本输入框输入相应的描述性文本(prompt),例如“一幅美丽的海边日落风景画”,然后选择合适的参数(如采样方法、生成步数、分辨率等),点击生成按钮,就能利用Stable Diffusion模型根据输入文本生成对应的图像。

- img2img模式:可以上传一张已有的图片,然后通过输入文本prompt以及调整相关参数,让模型基于上传的图片进行修改、变换等操作,生成新的符合要求的图像,比如上传一张简笔画的苹果,输入“把这个苹果变成红色且带有光泽的写实苹果”这样的prompt,模型就会对图片进行处理生成新的图像。

- 其他图像生成相关功能:像

Outpainting(向外扩展图像内容)、Inpainting(对图像中指定区域进行修改、填充等)、Color Sketch(根据草图生成彩色图像等)等功能,都能在对应的操作界面板块中进行参数设置和使用,满足多样化的图像创作需求。

- 图像编辑与处理功能:

- Upscale :可以对生成的图像或者上传的已有图像进行放大操作,通过选择合适的超分模型(如

GFPGAN、ESRGAN等)以及设置放大倍数等参数,提升图像的分辨率和质量。 - Negative prompt :在生成图像时,除了输入期望生成图像的prompt,还可以在这个额外的文本框输入不想在图像中出现的内容描述,比如不想图像中有绿色元素,就可以输入“no green”,帮助更好地控制生成图像的效果。

- Prompt Editing :在图像生成过程中,可以中途修改prompt,比如开始生成一个花朵的图像,过程中想改成生成一个带有花朵的花瓶图像,就可以利用这个功能进行调整,实现更灵活的图像创作。

- Upscale :可以对生成的图像或者上传的已有图像进行放大操作,通过选择合适的超分模型(如

- 模型与参数管理:

- Checkpoint Merger :可以选择最多3个不同的模型检查点(checkpoints)进行合并,融合不同模型的特点,生成新的自定义模型,便于后续生成具有独特风格或者效果的图像。

- Hypernetworks和Loras :能在对应的界面中选择加载不同的超网络或者Loras(一种轻量化的模型微调技术相关内容),将它们添加到prompt中,改变生成图像的风格、细节等特征,并且可以通过专门的界面进行选择、预览,方便对比和挑选合适的添加到创作中。

- Generation parameters :生成图像时使用的各种参数(如种子、采样器、分辨率等)会自动和图像关联保存(在PNG格式的图像中以PNG chunks形式保存,JPEG格式中保存在EXIF里),方便后续查看、复用这些参数,也可以通过相关按钮将图像中的参数重新加载到UI界面进行再次使用或者参考调整。

操作流程示例

- 生成一幅动漫风格的人物图像:

- 首先在

txt2img模式下的文本输入框输入类似“一个有着蓝色头发,大眼睛,穿着华丽古装的动漫女孩,微笑着,背景是粉色的樱花树”这样详细的prompt描述。 - 接着选择合适的采样器(比如常用的

Euler a等),设置生成步数(如20步左右,可根据实际效果调整),分辨率可以选择512×512或者根据需求调整大小,同时可以根据喜好选择是否添加一些超网络或者Loras来调整动漫风格的具体表现,比如选择一个偏向日系动漫风格的Loras。 - 点击生成按钮,等待片刻,就能在界面上看到生成的动漫风格人物图像,如果不满意还可以调整参数再次生成,或者利用图像编辑功能对生成的图像进一步优化处理。

- 首先在

注意事项

硬件要求相关

- GPU方面:虽然项目支持如4GB甚至2GB显存的显卡运行,但显存越大,在生成高分辨率图像或者进行复杂操作(如大量的超分处理、多轮img2img操作等)时会越流畅,效果也更好。对于NVIDIA显卡,如果想使用

xformers加速功能,需要显卡本身支持相应的技术特性,并且安装正确版本的xformers库,同时要在启动参数中正确配置开启该功能。AMD和Intel的GPU以及其他硬件加速设备(如Ascend NPUs)也有各自对应的适配情况和性能特点,要根据官方文档进行相应的配置和使用,避免因硬件不匹配或者未充分利用导致性能不佳等问题。 - CPU方面:在一些情况下,比如预处理图像、部分轻量级运算等环节会用到CPU,虽然不像GPU对图像生成影响那么大,但如果CPU性能过差,也可能导致整体处理速度变慢,尤其是在处理大量图像或者复杂任务队列时,所以建议使用性能较好的多核CPU,并且保证系统资源分配合理,避免出现CPU占用过高导致系统卡顿等情况。

软件及库版本问题

- Python版本:如前面提到,不同操作系统下推荐的Python版本有所不同,要严格按照要求安装,使用不兼容或者不合适的Python版本可能导致项目无法启动或者运行过程中出现各种奇怪的错误,比如某些依赖库安装不上、函数调用异常等情况。

- 其他依赖库版本:项目根目录下的

requirements.txt等文件中规定的依赖库版本是经过测试相对稳定的组合,随意更改版本(尤其是升级到过高版本或者使用过低版本)可能会出现接口不兼容、功能缺失或者新的未修复的bug等问题,所以在更新依赖库时要谨慎,最好先了解其对项目的影响,必要时可以在测试环境先进行验证后再应用到正式使用环境中。

模型使用与版权问题

- 模型来源与合法性:项目中使用的Stable Diffusion相关模型等,其基础模型有对应的版权归属(如来自Stability-AI等机构),在使用时要确保遵循相应的开源协议和使用规则,不能用于非法或者违反协议的商业用途等情况。对于一些自定义训练或者合并生成的模型,也要保证训练数据来源合法合规,避免出现版权纠纷。

- 模型加载与格式问题:项目支持加载如

safetensors格式的模型检查点等,在下载和使用模型时要注意格式是否正确,并且按照项目要求的方式进行加载,若模型格式错误或者加载路径等设置不对,可能导致模型无法正常使用,无法生成预期的图像效果。

常见错误及解决办法

- 启动报错:如果启动项目时出现类似“找不到某个模块”的错误,大概率是依赖库没有安装正确,可以检查

requirements.txt文件中对应的库是否安装,尝试重新安装该库;若是提示“端口被占用”等问题,可以查看是哪个程序占用了相应端口,关闭占用程序或者修改项目启动的端口号(在配置文件中查找对应的端口配置参数进行修改)。 - 图像生成异常:生成图像时如果出现图像模糊、颜色异常等情况,首先检查生成参数是否合理,比如采样步数是否过少、分辨率设置是否合适等;若出现生成的图像不符合prompt描述的情况,一方面可以调整prompt的表述使其更清晰准确,另一方面可以尝试更换不同的采样器或者添加合适的超网络、Loras等来改善效果;如果是一直处于生成中但长时间无结果,可能是硬件资源不足(如GPU显存耗尽等),可以适当降低参数(如分辨率、批量生成数量等)重新尝试生成。

项目地址:https://github.com/AUTOMATIC1111/stable-diffusion-webui