字数 1072,阅读大约需 6 分钟

深入探讨众包AI基准测试的争议与挑战

随着AI实验室越来越依赖如Chatbot Arena[1]这样的众包平台来评估新模型的能力,专家们对此表示担忧。Emily Bender,华盛顿大学语言学教授及《AI骗局》一书的合著者,对Chatbot Arena提出了质疑。她认为,一个有效的基准测试需要测量特定的内容,并具备结构有效性,即所关注的结构需要被明确定义,且测量结果应与该结构相关。然而,Chatbot Arena并未证明用户对不同输出的投票与偏好之间存在关联。

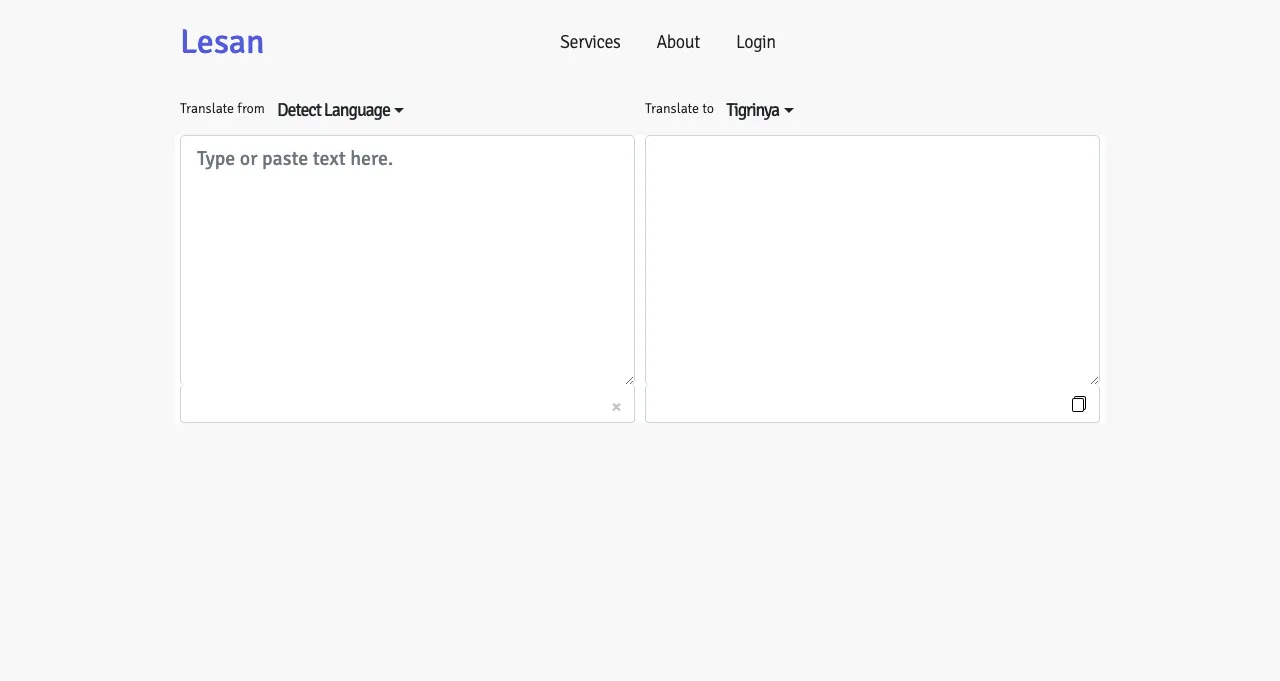

Asmelash Teka Hadgu,AI公司Lesan的联合创始人及分布式AI研究研究所的研究员,指出像Chatbot Arena这样的基准测试正被AI实验室利用,以夸大其模型的性能。他引用了Meta的Llama 4 Maverick模型的争议为例,Meta调整了Maverick的版本以在Chatbot Arena上获得高分,但最终发布的却是性能较差的版本。

改进基准测试方法的呼吁

Hadgu主张基准测试应该是动态的而非静态的数据集,并应由多个独立的实体(如组织或大学)分布式进行,针对特定应用场景(如教育、医疗等)进行定制化。他还与Aspen Institute的前Emergent和Intelligent Technologies Initiative负责人Kristine Gloria共同呼吁,应为参与模型评估工作的志愿者提供合理的补偿。Gloria指出,AI实验室应从数据标注行业的错误中吸取教训,避免剥削性做法。

Matt Fredrikson,Gray Swan AI的CEO,该公司为模型运行众包红队测试活动,他表示志愿者参与其平台的原因包括学习和实践新技能。尽管Gray Swan也为一些测试提供现金奖励,但Fredrikson承认公共基准测试不能替代付费的私人评估。他强调,开发者还需要依赖内部基准测试、算法红队和具备特定领域专业知识的合同制红队人员。

LMArena的应对措施与未来展望

Alex Atallah,模型市场OpenRouter的CEO,该公司最近与OpenAI合作,为用户提供早期访问OpenAI的GPT-4.1模型的机会,他认为仅进行开放测试和基准测试是不够的。同样,UC伯克利的AI博士生Wei-Lin Chiang,也是LMArena(维护Chatbot Arena)的创始人之一,表示支持使用其他测试。他们的目标是创建一个值得信赖的开放空间,以衡量社区对不同AI模型的偏好。

Chiang表示,像Maverick基准测试差异这样的事件并不是Chatbot Arena设计缺陷的结果,而是实验室对其政策的误解。为了预防未来出现类似问题,LMArena采取了一系列措施,包括更新政策以强调对公平、可重复评估的承诺。Chiang强调,LMArena的社区成员并非志愿者或模型测试人员,而是希望在一个开放、透明的环境中与AI互动并提供集体反馈的用户。只要排行榜忠实地反映了社区的声音,他们就欢迎其被分享。