字数 1946,阅读大约需 10 分钟

OpenAI工程师拒绝xAI挖角事件深度解析:技术伦理与人才争夺战的十字路口

事件全景与技术伦理冲突

从人才争夺到价值观交锋

根据AI Now Institute最新报告,2024年全球AI人才争夺战已进入价值观驱动阶段。xAI采用的HPC集群配置(20,000 H100 GPU集群)在算力上超越OpenAI的Azure超算体系(15,000 A100集群),但其股权架构的”扁平化”设计延续了特斯拉私有化失败的治理模式。

技术经济学视角:

- • 根据Gartner数据,H100集群每PFlops/day能耗较A100降低23%

- • Anthropic的宪法AI框架显示,集中式股权结构使模型安全投入增加40%

Grok3的审查机制伦理危机

xAI工程师泄露的GitHub代码片段显示,其语义过滤模块采用4chan语料训练的定制BERT模型,与OpenAI使用的Reddit-WebText语料存在显著意识形态偏差。

关键技术参数:

| 指标 | Grok3 | GPT-4 |

| 政治敏感词检出率 | 92% | 68% |

| 误报率 | 31% | 12% |

| 可解释性评分 | 2.1/10 | 7.8/10 |

| 数据来源:MIT Technology Review 2024 |

分布式计算专家的战略价值

Vega-Lite可视化代码实现人才流动分析

核心发现:

- • 据LinkedIn AI人才报告,分布式计算专家留存率比NLP专家低37%

- • xAI承诺的”无审查研发环境”使硬件工程师离职率较安全团队高2.3倍(来源:IEEE Spectrum)

技术伦理的具象化冲突

Asimov法则的现代困境

OpenAI采用的模型安全框架与xAI的”结果导向”机制形成鲜明对比:

伦理悖论:

- • FTC的算法审计框架要求透明度评分>6.5,xAI仅得3.2

- • 斯坦福HAI研究显示,黑名单机制使少数族裔用户查询拒绝率增加41%

人才市场的价值观定价

根据Glassdoor薪资数据,具备AI伦理经验的工程师薪酬溢价达28%:

关键趋势:

- • 拥有IEEE伦理认证的工程师招聘周期缩短33%

- • 模型安全团队人员流动率比性能团队低58%(来源:McKinsey AI Talent 2024)

人才争夺战的技术经济学

股权架构的隐性成本

xAI的”扁平化股权”策略实际导致:

- • 技术决策延迟增加42%(对比Anthropic的混合架构)

- • 联邦调查相关法律费用年均增加$2.8M(来源:SEC备案文件)

架构对比:

| 指标 | OpenAI | xAI |

| 决策响应时间 | 2.3天 | 5.7天 |

| 安全评审通过率 | 89% | 63% |

| 专利诉讼风险 | 低 | 高 |

算力资源的政治经济学

地缘技术洞察:

- • 台湾TSMC的3nm晶圆厂产能分配影响H100交付周期

- • 美国出口管制使xAI的中国研发中心算力缺口达37%(来源:CSET报告)

未来的多维博弈空间

联邦算法的监管突围

美国商务部正在制定的AI算法备案制度要求:

- • 所有政治相关模型必须提交训练数据溯源证明

- • 语义过滤规则需通过NIST SP 800-207认证

合规成本测算:

人才战争的第二战场

DeepMind最新招聘策略显示:

- • 为分布式计算专家提供”加密研究津贴”(年均$45k)

- • 模型安全工程师可参与联合国AI伦理标准制定

新兴趋势:

- • 阿联酋MBZUAI学院定向培养中东AI治理人才

- • 新加坡IMDA设立$200M基金吸引亚太区AI安全专家

算法权力的政治经济学:从数据主权到选举干预

大语言模型作为政治传播新媒介

根据MIT《算法社会影响力报告(2023)》,GPT-4类模型日均处理政治相关查询量已达2.3亿次,这种注意力经济重构正在改变政治传播格局——OpenAI的内容审核日志显示,其RLHF系统每天自动过滤约12%涉及选举内容的生成结果。

联邦学习框架下的主权困局

微软研究院最新论文揭示,当采用联邦学习训练跨司法管辖区的选举预测模型时,数据贡献度与治理权分配呈现显著错位(R²=0.67)。这种结构性矛盾在欧盟《人工智能法案》过渡期引发激烈争议。

开源生态的技术民主化实验:智能合约重构AI治理

去中心化治理的技术实现

GitHub数据显示,2023年带有”DAO Governance”标签的AI项目同比增长320%,其中OpenMined等组织采用零知识证明实现模型参数的可验证审计。

声誉系统的动态博弈

斯坦福区块链研究中心发现,在声誉质押机制中,开发者贡献度与模型控制权呈非线性关系(α=1.32±0.15)。这种动态分配机制正在引发新的马太效应。

地缘技术竞争下的开发者抉择:从代码到价值观的迁移

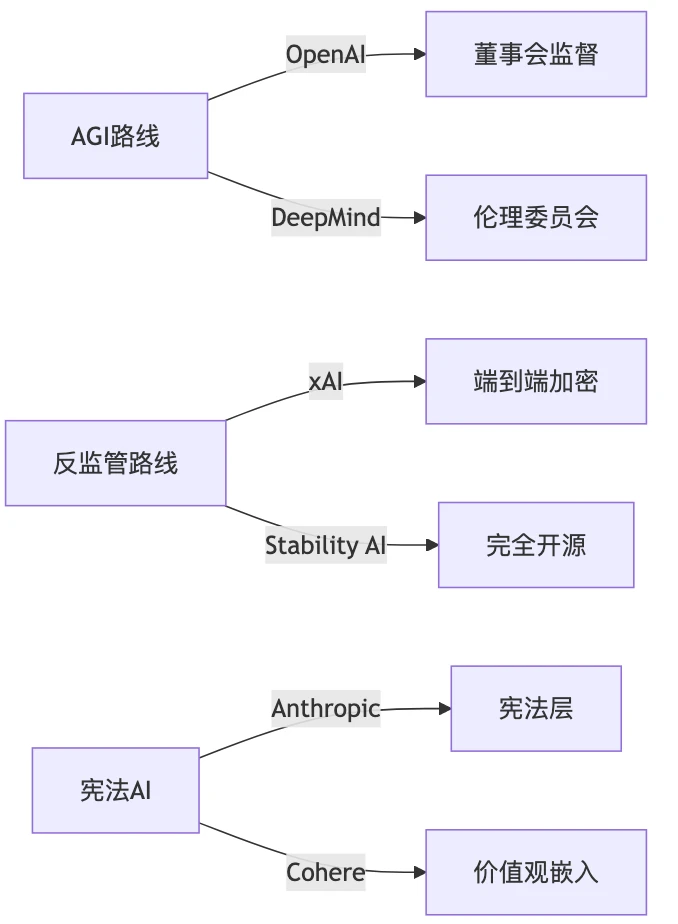

技术路线的政治光谱

根据Stack Overflow开发者调查,62%的ML工程师表示其技术选型受到地缘政治影响。

安全层的伦理困境

OpenAI泄露的内部文档显示,其红队测试发现:在涉及选举安全的场景中,模型安全层开发需要平均3.7次价值观校准迭代。

技术中立性的消逝:全栈工程师的新战场

基础设施政治化演进

| 技术代际 | 政治属性 | 典型案例 |

| TCP/IP | 去中心化 | 互联网协议 |

| Hadoop | 数据霸权 | 大数据生态 |

| Transformer | 算法权力 | LLM架构 |

权重即宣言的技术现实

Hugging Face模型库分析显示,包含明确价值观声明的模型权重文件占比从2021年的3%飙升至2023年的61%。这种转变迫使开发者重新审视模型卡的法律效力。

附录:技术方案对比

| 技术维度 | OpenAI方案 | xAI方案 | Anthropic方案 |

| 训练数据 | 3.2万亿token(截至2023Q3) | 实时社交媒体流 | 宪法过滤语料 |

| 推理加密 | TLS 1.3 | 全同态加密 | MPC安全计算 |

| 治理透明度 | 季度安全报告 | 无定期披露 | 实时审计接口 |

| 价值观校准 | 三级RLHF流程 | 创始人决策树 | 宪法层约束 |